Дискриминация (от лат. discriminatio -различение) в математической статистике – выявление различий между объектами исследования. Если общества развитых стран борются с дискриминацией, то для статистиков – это хлеб насущный.

Итак, дискриминантный анализ служит для выявления линейных зависимостей между двумя и более группами. Он является как разведочным, так и подтверждающим. То есть, мы можем как найти статистические зависимости обуславливающие различие между группами, так и использовать их для дальнейшей дискриминации других объектов.

Сам по себе дискриминантный метод является линейным методом, а потому имеет много общего с дисперсионным (ANOVA) и регрессионным методами.

Данный метод предъявляет ряд требований к данным:

- Нормальность признаков

- Одинаковая дисперсия признаков в группах

- Различие в средних

В принципе, данными условиями можно пренебречь. Главное, что бы работало. При этом чем меньше соблюдаются условия – тем меньше будет процент верной классификации. Вот и всё.

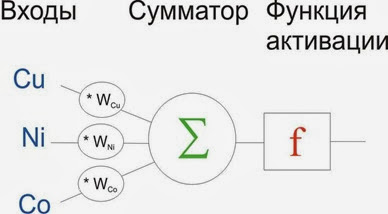

Важно отметить, что в геохимии мы имеем дело, как правило, с нелинейными закономерностями. Но это не означает, что линейные функции подходят неудовлетворительно. По своему опыту дискриминации интрузий, аномалий и пр. объектов, – использование нейросетей для дискриминации позволяло улучшить результат всего на 2-5%.

Приступим…

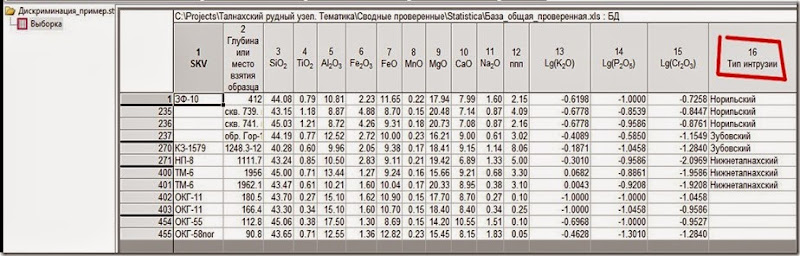

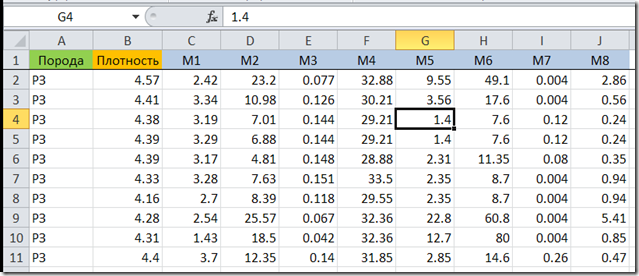

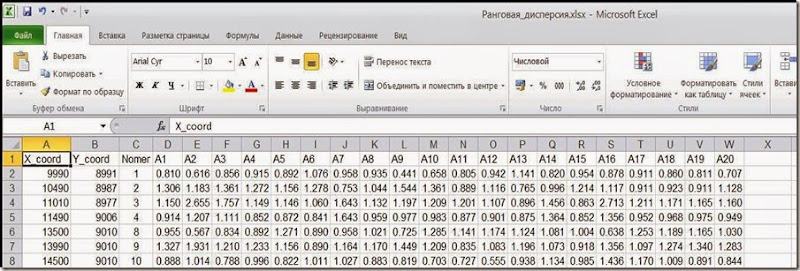

Допустим мы имеем выборку силикатных анализов трёх типов интрузий: Норильский тип - продуктивный и несёт оруденение; Зубовский – похож на Норильский, но непродуктивный; Нижнеталнахский – совсем “пустой”. Дополнительно, в выборку добавлен ряд проб с нового объекта и нам потребуется выяснить к какому типу относится он. Важно отметить, что в нашем случае, каждый тип охарактеризован разным количеством проб в силу неравномерности изучения, но никак не природной встречаемости (это важно).

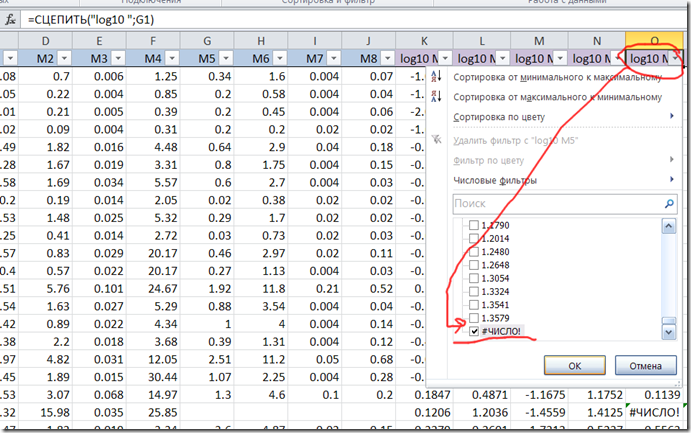

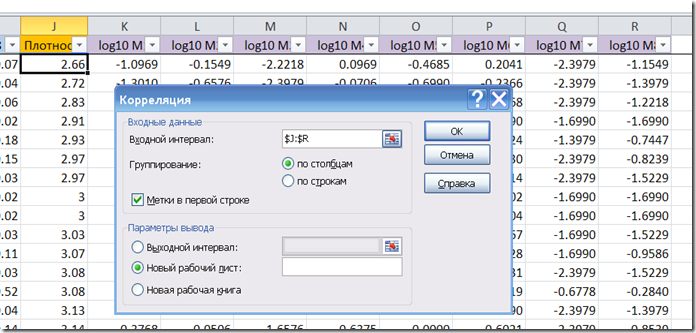

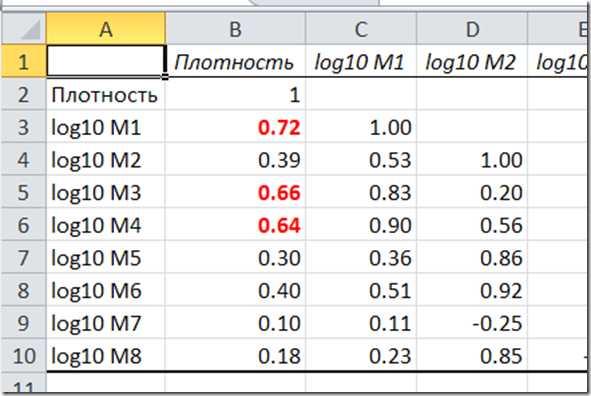

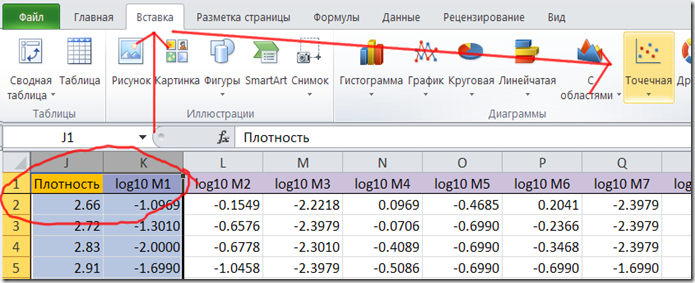

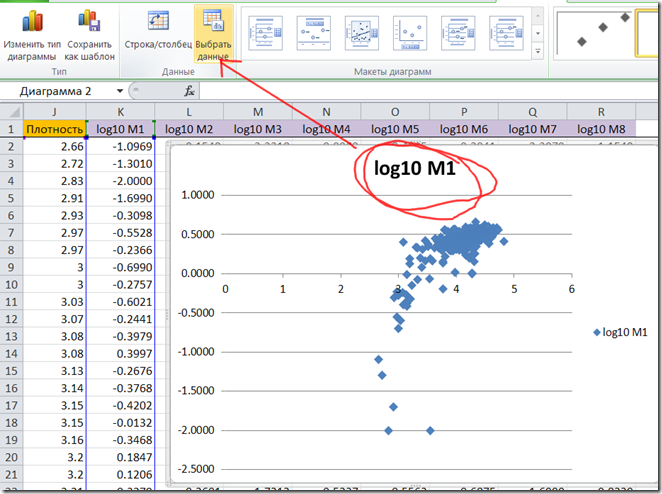

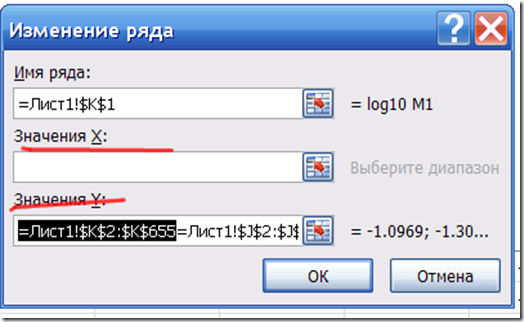

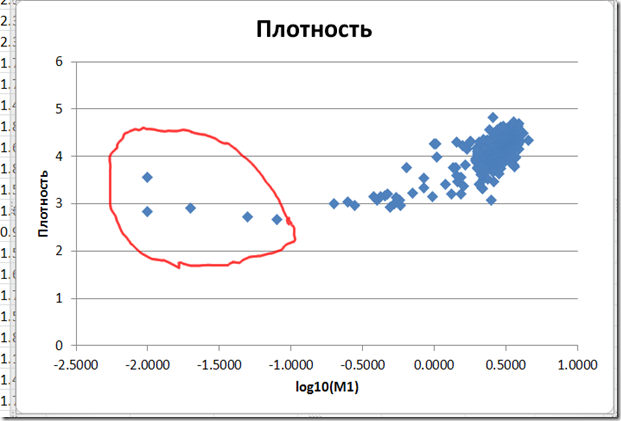

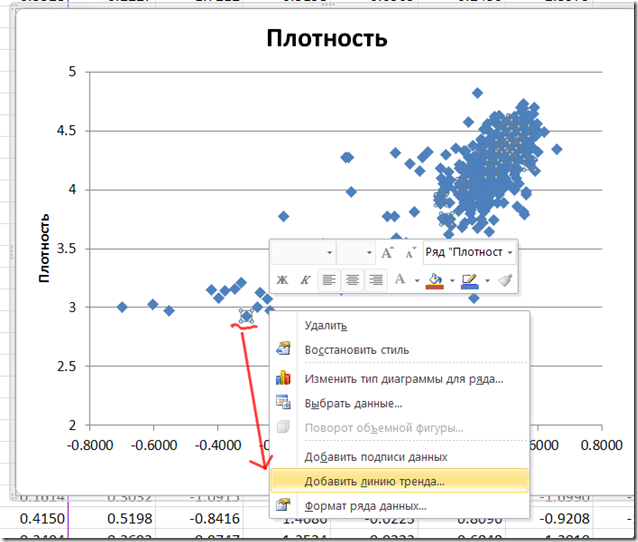

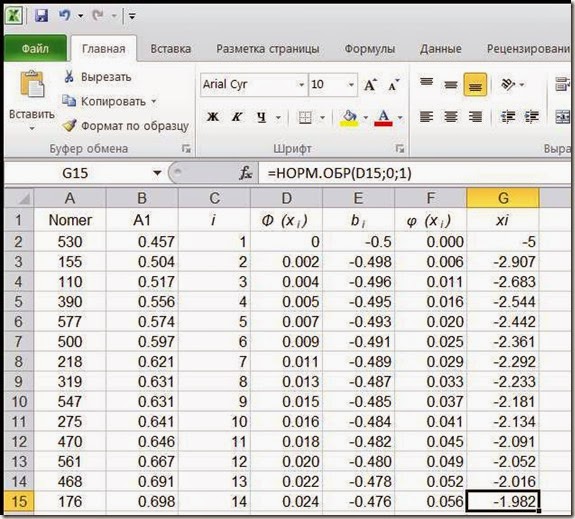

Лог-нормальные данные были предварительно прологарифмированы. О том, как проверить данные на нормальность – см. ранние посты.

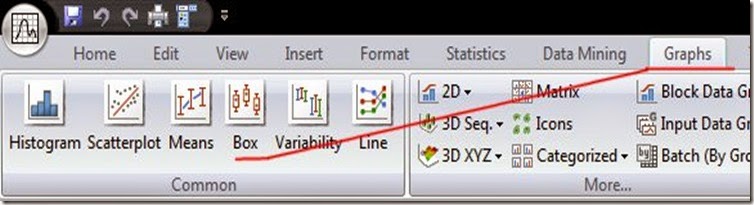

Рис. 2. Строим графики типа ящик-с-усами.

Рис. 2. Строим графики типа ящик-с-усами.

Данные графики показывал как строить ранее, потому у вас затруднений не должно быть.

Графики типа ящик-с-усами показывают различие в средних и дисперсии, то что нам нужно для предварительной разведки данных.

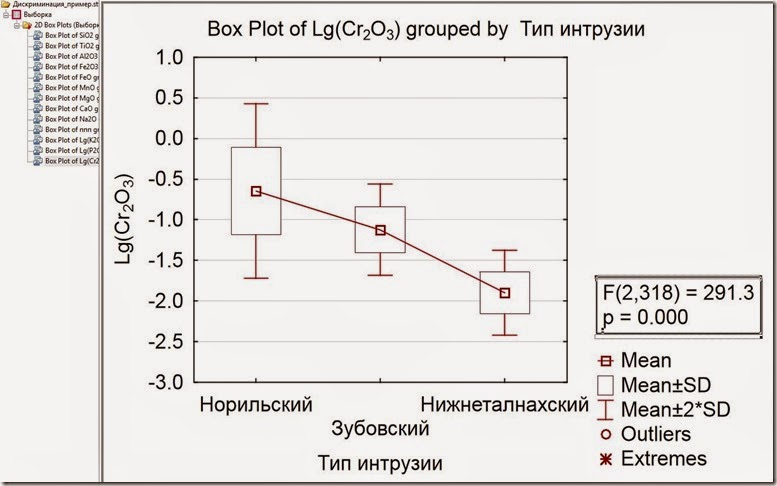

Рис. 3. График распределения оксида хрома по типам интрузий.

Рис. 3. График распределения оксида хрома по типам интрузий.

Типичный график с высоким различием объектом. Посмотрите, ящики Норильского и Нижнеталнахского типов не пересекаются, средние однозначно различаются. Дисперсия (ширина ящика) у Норильского типа выше, но этим можно пренебречь. Теоретически, можно проводить дискриминацию уже по оксиду хрома – посчитать необходимое количество проб, и вперед, но мы хотим большего – большей надежности и качества за счёт использования других переменных.

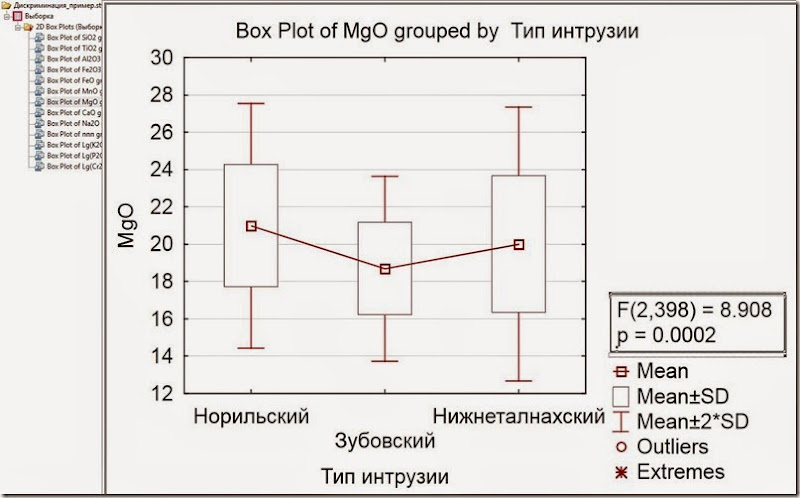

Рис. 4. График распределения оксида марганца по типам интрузий.

Рис. 4. График распределения оксида марганца по типам интрузий.

Типичный график со слабым различием между группами.

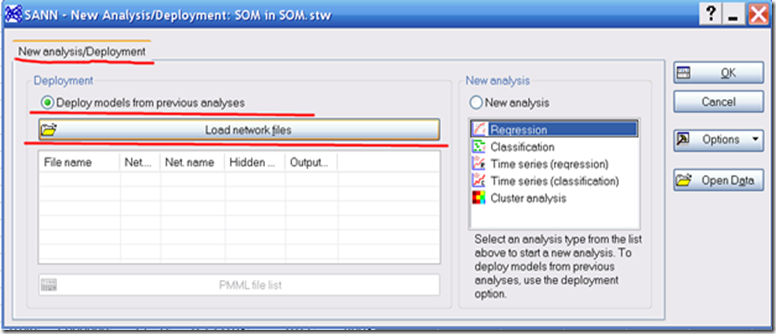

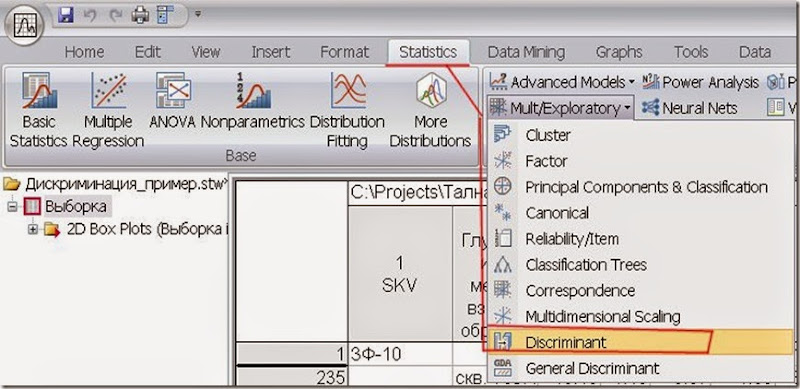

Рис. 5. Традиционный дискриминантный анализ.

Рис. 5. Традиционный дискриминантный анализ.

Ниже есть выбор анализа General Discriminant (Общий дискриминантный). Для него доступны категориальные независимые переменные (у геохимиков, это например, название вмещающих горных пород, их возраст; у кредиторов – внешний вид заёмщика). Так же, там имеется кросс-проверка результатов. Тем не менее, выбрал “традиционный” анализ, потому что в таком случае можно еще провести канонический анализ и полнее расммотреть зависимости.

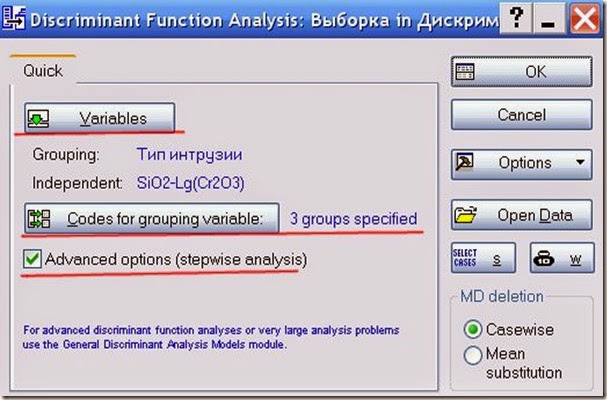

Рис. 6. Определение переменных и групп для анализа.

Рис. 6. Определение переменных и групп для анализа.

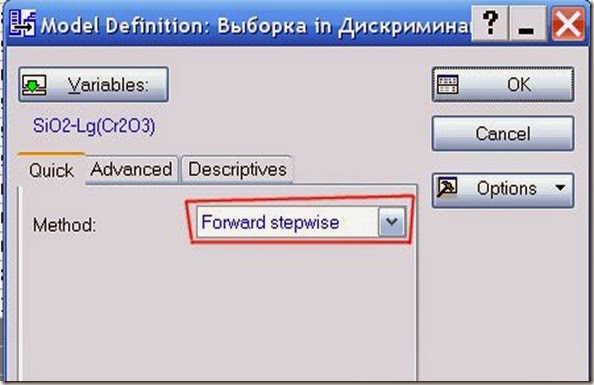

Рис. 7. Выбор параметров проведения анализа.

Рис. 7. Выбор параметров проведения анализа.

В данном случае можно выбрать один из трёх методов выбора переменных:

- стандартного, когда включаются сразу все переменные;

- последовательного включения, когда включаются данные у которых F больше определённого значения (уточняется в Advanced);

- последовательного исключения, когда из всех переменных исключаются те, у которых значение F меньше определённого значения (выставляется в Advanced).

F значение – отношение межгрупповой дисперсии к внутригрупповой.

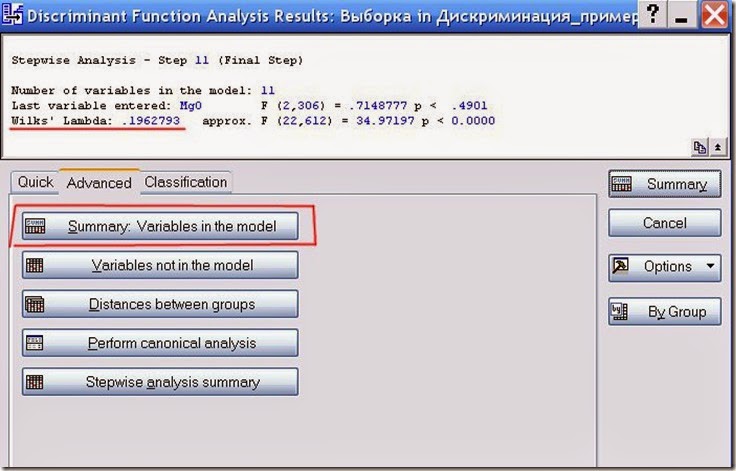

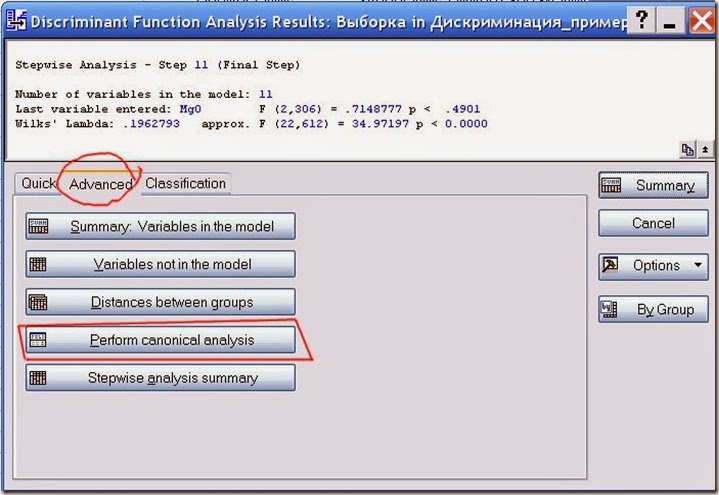

Рис. 8. Итоговая характеристика анализа.

Рис. 8. Итоговая характеристика анализа.

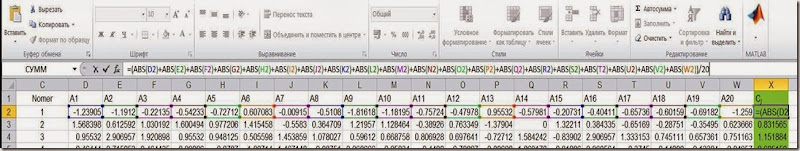

Итак, из тринадцати переменных анализ выбрал одиннадцать. Последней включённой переменной оказался оксид магния с F = 2,306. Лямбда Уилкса составила 0,19, что близко к нулю и является хорошим результатом. То есть, можно ожидать выского процента верной классификации.

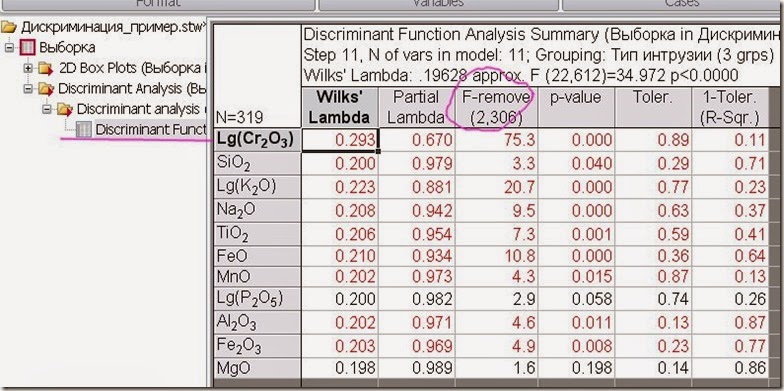

Рис. 9. Таблица переменных участвовавших в дискриминантном анализе.

Рис. 9. Таблица переменных участвовавших в дискриминантном анализе.

Как видно из таблицы, максимальные различия вносят переменные оксида хрома, калия, и железа II.

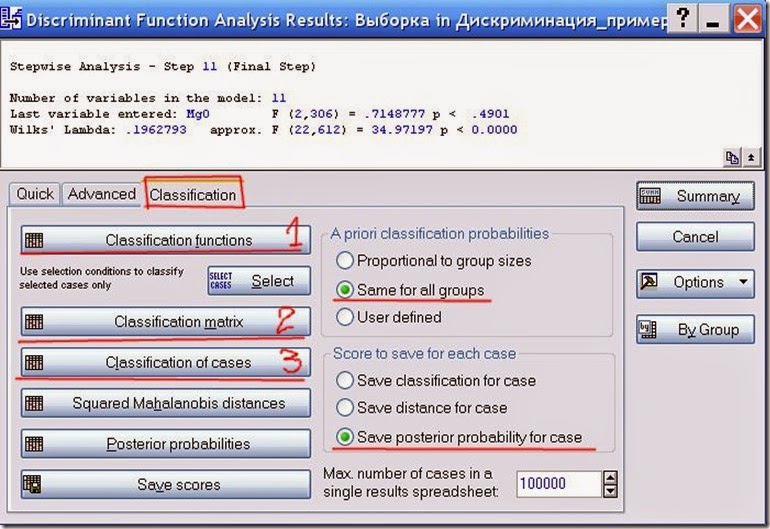

Рис. 10. Результаты классификации.

Рис. 10. Результаты классификации.

Перед выводом отчётных таблиц необходимо определиться с априорными вероятностями (Apriori classification probabilities). Как говорил в самом начале, у нас количество проб не влияет на природную встречаемость интрузий, а обусловлено лишь неравномерным изучением объектов. Поэтому следует выбрать равнозначные априорные вероятности. Тем не менее, если вы имеете априорную информацию (например, встречаемость интрузий в конкретном районе, или вероятность нахождения интрузий по геофизическим данным), или хотите подстраховаться, то можно самостоятельно расставить априорные вероятности через пункт User Defined.

Затем выведем таблицы: фукнций классификации, матрицы классификаций и таблицу классификации проб. Каждая таблица зависит от априорных вероятностей.

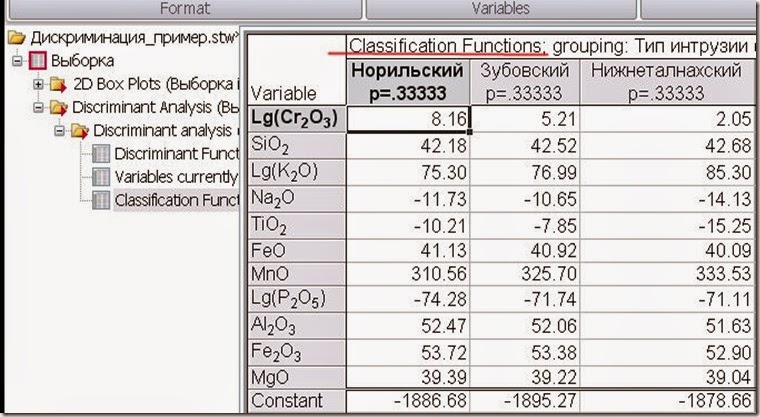

Рис. 11. Функции классификации.

Рис. 11. Функции классификации.

Так то тут представлены коэффициенты к дискриминантным функциям типа y=ax+b. Выигрывает тот тип, значение дискриминантной функции которого принимает максимальное значение.

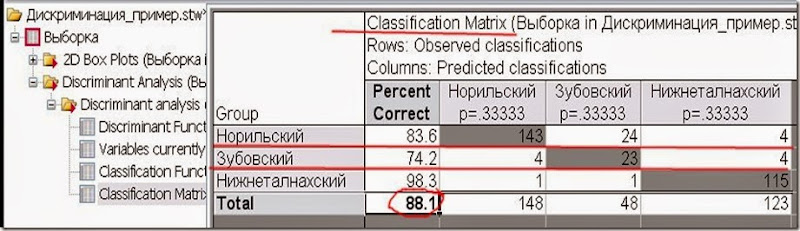

Рис. 12. Матрица результатов классификации.

Рис. 12. Матрица результатов классификации.

В строках матрицы - наблюдаемые значения, в колонках – предсказанные. Таким образом, Норильский тип чаще всего путаем с Зубовским, и реже с Нижнеталнахским.

Верная классикация происходит в 88% случаев, зная это с помощью биномиального распределения можно расчитать необходимое количество проб для дискриминации объектов.

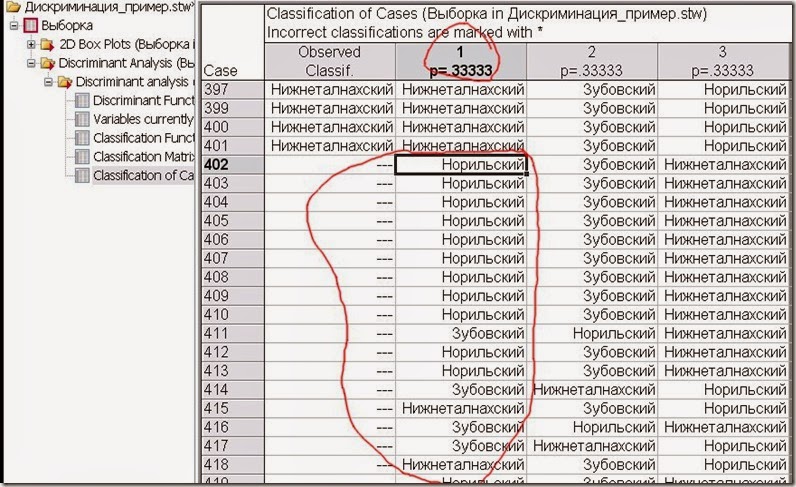

Рис. 13. Таблица результатов классификации.

Рис. 13. Таблица результатов классификации.

В выборку были добавлены пробы без определённого типа интрузии, но они так же были проанализированы и в большинстве своём относятся к Норильскому типу.

Рис. 14. Проведение канонического анализа.

Рис. 14. Проведение канонического анализа.

Канонический анализ – аналогичен методу главных компонент и служит для выявления связей между двумя и более множествами переменных.

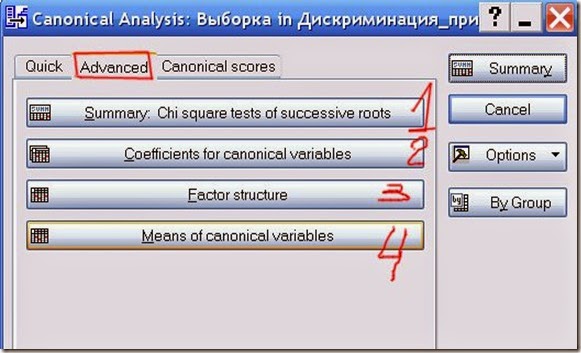

Рис. 15. Параметры канонического анализа.

Рис. 15. Параметры канонического анализа.

Выбираем таблицы.

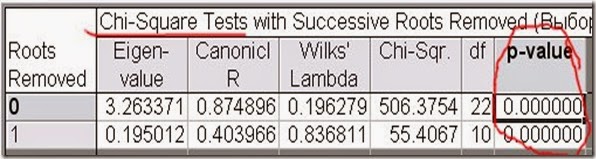

Рис. 16. Тест Хи-квадрат канонических корней.

Рис. 16. Тест Хи-квадрат канонических корней.

В данной таблице показываются все канонические корни и их статистическая значимость. Обращаем внимание на значимые корни. В данном случае, два корня и оба статистически значимы.

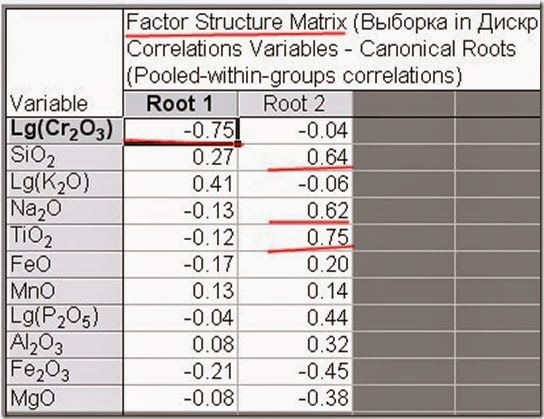

Рис. 17. Факторный анализ канонических корней.

Рис. 17. Факторный анализ канонических корней.

Объяснить структуру канонических корней можно по таблице факторных нагрузок, которая аналогична одноименной в факторном анализе. Если кто сомневается, то можно подглядеть в графики типа ящик-с-усами.

Если рассмотреть данную таблицу вместе с графиков канонических значений (рис. 19), то увиидим, что чем меньше значение Lg(Cr2O3) и блольше Lg(K2O) тем больше значение Корня 1, а значит, тем более вероятнее классификация Нижнеталнахского типа. Корень 2 разделяет Норильский и Зубовский типы: чем больше SiO2, Na2O и FeO и чем меньше Fe2O3 и MgO, тем более вероятен Зубовский тип.

Получается, что для Нижнеталхнаского типа характерна калиевая специализация с обедненностью хромом, а для Норильского типа характерна хромово-магниевая специализация с повышенной окисленностью железа.

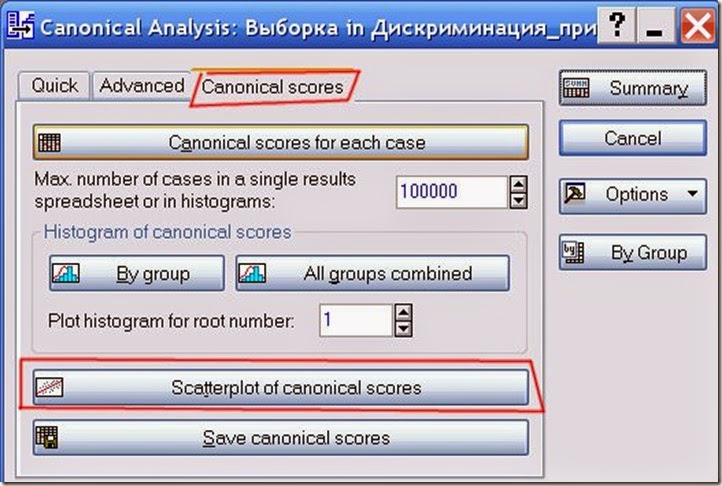

Рис. 18. Построение графика распределения канонических значений.

Рис. 18. Построение графика распределения канонических значений.

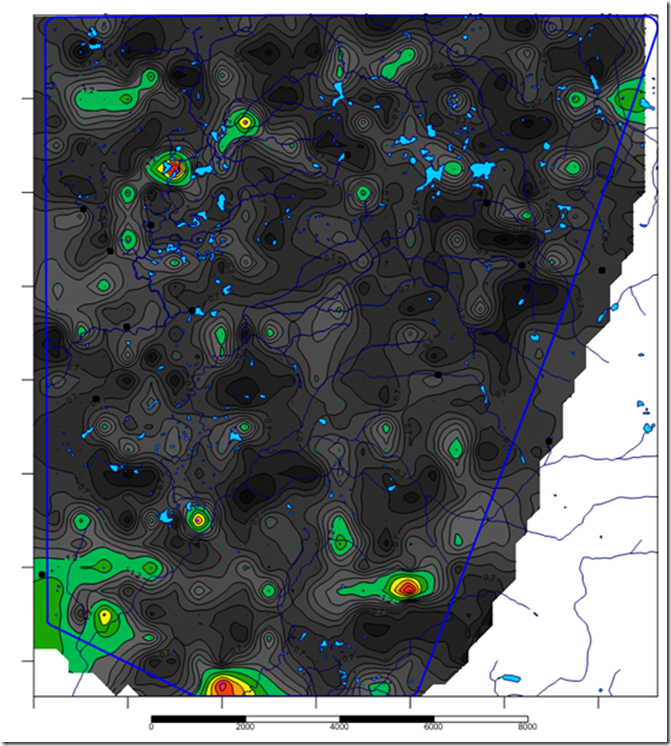

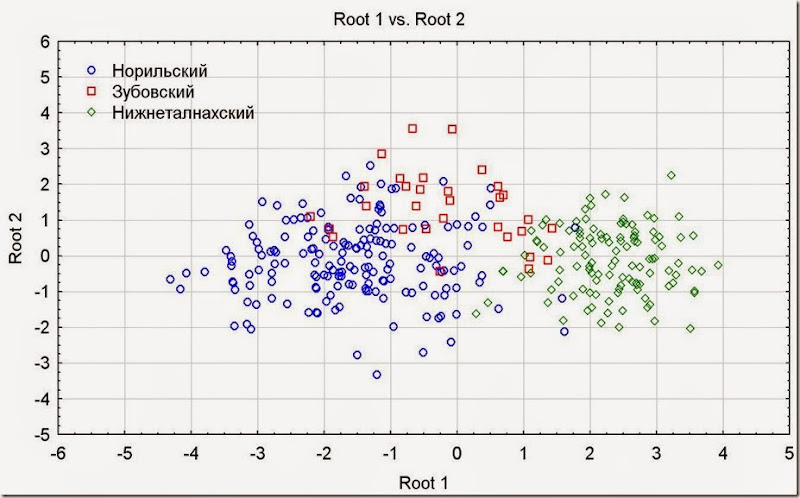

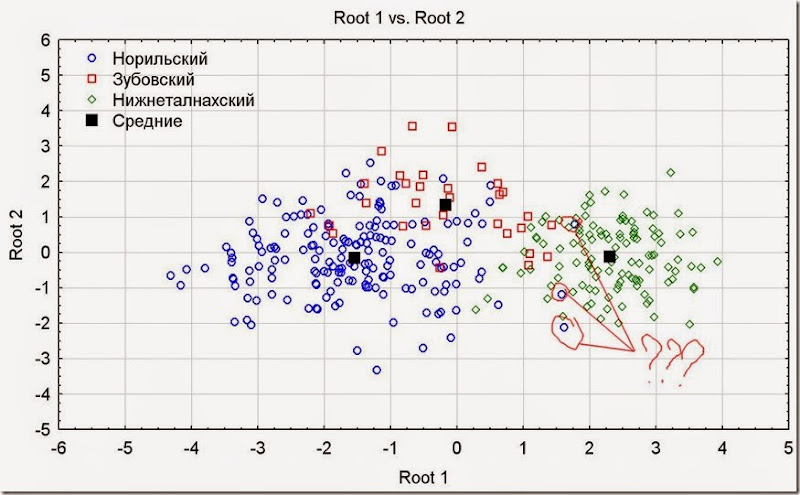

Рис. 19. График распределения канонических значений.

Рис. 19. График распределения канонических значений.

Рис. 20. Добавление средних значений на график.

Рис. 20. Добавление средних значений на график.

Поскольку, в дискриминации всё упирается в средние значения, то логично вынести их на график. Скопируем средние значения канонических корней из соответствующей таблицы.

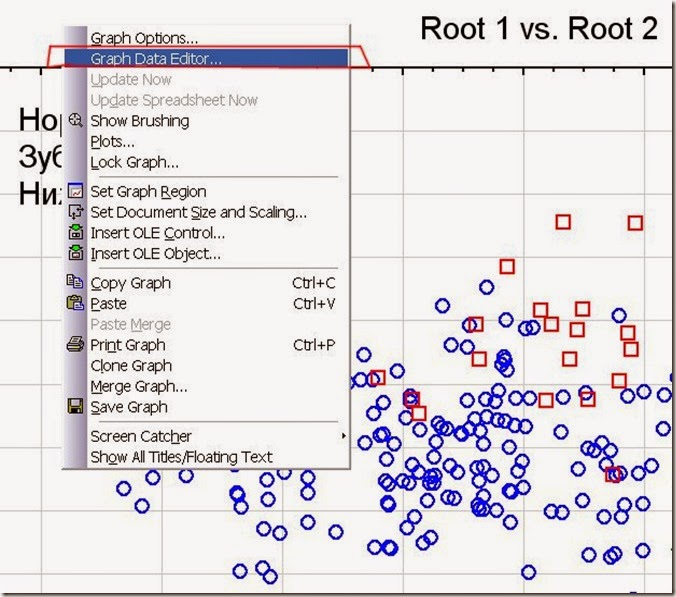

На графике щёлкам правой клавишей мышки и выбраем пункт “Graph Data Editor” – редактор данных графика

Рис. 21. Добавление нового графика.

Рис. 21. Добавление нового графика.

В любом месте щелкаем правой клавишей мышки и выбираем пункт “Add new plot” – добавить новый график. Вставляем скопированные средние значения.

Рис. 22. Итоговый график распределения канонических значений.

Рис. 22. Итоговый график распределения канонических значений.

Канонические корни аналогичны факторам – являются латентными призаками. То есть все отдельные особенности переменных объединяются в новые математические переменные. Они не являются доказательством определённых геохимических процессов проиходивших в недрах, но могут их отражать, потому называются латентными. Удобство сокращения тринадцати переменных в две на глазах.

Кроме всего, на графике можно посмотреть форму групп, их положение, а так же наличие ошибок в данных – если пробы отходят сильно далеко от своих групп, то скорее всего они являются ошибочно классифицированными, вплоть до определения нового типа интрузии.

На графике, например, можно увидеть отдалённые три пробы Норильского типа, которые находятся в поле Нижнеталнахского. Надо их проверить.

Вот собтственно и всё.